Hany Farid nije se mogao oteti dojmu da zapravo ne razgovara s Barackom Obamom.

Godine 2023. jedan je Obamin pomoćnik kontaktirao Farida, profesora računalnih znanosti na kalifornijskom sveučilištu Berkeleyju koji se specijalizira za analizu slika i digitalnu forenziku i pitao ga bi li porazgovarao s bivšim predsjednikom o deepfake tehnologiji. Obamin glas i melodija govora tijekom videopoziva bili su prepoznatljivi kao i uvijek, ali profesoru nešto nije dobro sjelo. "Cijelo vrijeme sam mislio: 'Ovo je deepfake. Ovo nije Obama'", kaže Farid. "Htio sam mu reći: 'Stavi ruku ispred lica.'"

Tada je jedan od načina za prepoznati deepfake bio tražiti nekoga da maše rukom ispred lica. Ako bi se slika iskrivila, razotkrili biste prevaranta. No, Farid se nije mogao natjerati da pogleda bivšeg predsjednika u oči i zamoli ga da mu dokaže da su te oči stvarne. "I tako sam se 10 minuta pitao: 'Jesam li na skrivenoj kameri?'", objašnjava Farid.

Čitaj više

Perplexity je novi pit bull umjetne inteligencije

Najnovije dvije tužbe samo su se pridružile već dugom popisu nezadovoljnika načinom na koji Perplexity prikuplja sadržaj.

11.11.2025

Ulaganja u umjetnu inteligenciju mjere se u milijardama, a chatbotovi nam lažu

Studija Europske radiodifuzijske unije (EBU) otkrila je zabrinjavajuće stope pogrešaka među popularnim AI chatbotovima. Vjerovali ili ne, jedan od tri odgovora je izmišljen.

10.11.2025

Google traži odgovor na ChatGPT

U tijeku su velike promjene najpopularnijeg proizvoda na internetu, a Google (i mreža) možda više nikad neće biti isti.

07.05.2025

Portal Chatbot Arena najavio je uspon DeepSeeka prije svih drugih

Stranica na kojoj korisnici ocjenjuju chatbote postala je način na koji stručnjaci za umjetnu inteligenciju dobivaju informacije o najboljim modelima.

11.04.2025

Ispostavilo se da ga nitko ne vara. Ipak, Faridovo nepovjerenje je simptomatično jer pokazuje koliko je paranoje umjetna inteligencija uvela u online komunikaciju. Tehnologija se brzo razvija i zaobilazi čak i najočitije sustave prepoznavanja ljudskih bića. Trik mahanja rukom već je zastario, što je Farid za Bloomberg Businessweek pokazao na nedavnom videopozivu, zamijenivši svoje lice onime glavnog izvršnog direktora OpenAI-a, Sama Altmana. Glas mu nije bio savršeno sinkroniziran s videom i oči su mu djelovale pomalo beživotno, ali Farid se uspio počešati po obrazu i usmjeriti svjetiljku prema glavi bez ikakvog ometanja slike. "U načelu", tvrdi Farid, "možemo se oprostiti s idejom da znamo s kime razgovaramo preko videopoziva."

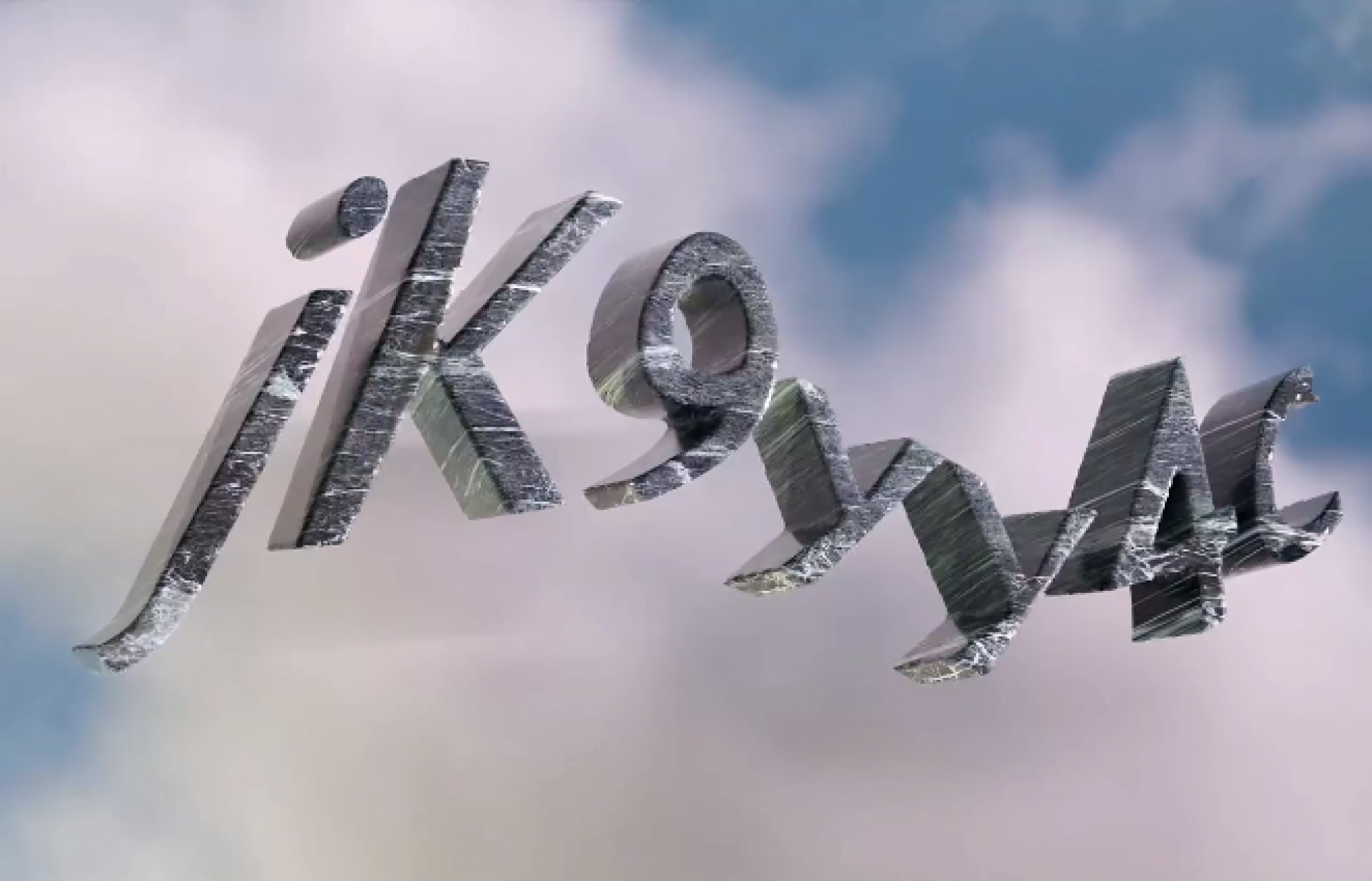

Ljudi se pripremaju za dan kada će strojevi moći uvjerljivo oponašati ljude još od 1950. godine, kada je Alan Turing predložio način evaluacije koji je prozvao "igra oponašanja". U tzv. Turingovom testu, od osobe se traži da se dopisuje sa strojem i drugim čovjekom, a ona zatim mora pokušati pogoditi koji odgovori pripadaju stroju, a koji čovjeku. Ako je stroj uspješno prevari, to znači da je položio test. Desetljećima kasnije, web stranice redovito traže od korisnika da dokažu svoju ljudskost dešifriranjem iskrivljenih slova i brojeva poznatih kao CAPTCHA, koje ljudi čitaju bez poteškoća, ali se zato računala s njima muče (akronim je kratica za Completely Automated Public Turing test to tell Computers and Humans Apart, odnosno "Potpuno automatizirani javni Turingov test za razlikovanje računala i ljudi"). Kako su automatizirani alati postajali sofisticiraniji, tako su se razvijale i te digitalne zamke. Postajale su i sve neobičnije, kao na primjer kad se ljude tražilo da izdvoje fotografije pasa koji se smiješe (mogu li se psi uopće smiješiti?) samo da bi kupili neke ulaznice za koncerte.

Pojava velikih jezičnih modela probila je te obrambene bedeme. Istraživanja su pokazala da AI agenti, uz pažljivo sastavljene promptove, mogu riješiti složene CAPTCHA zadatke. U jednom nedavnom istraživanju od 126 sudionika je nekoliko modela ispitano Turingovim testom. U 73 posto slučajeva ljudi su mislili da je OpenAI-ev model GPT-4.5 čovjek.

U svijetu u kojem je internet glavni medij, povjerenje se raspada, a svaka interakcija može biti kvalitetna obmana, bilo da se radi o potencijalnom poslodavcu, budućem ljubavnom partneru, pozivu vaše majke s odmora u inozemstvu ili bivšem američkom predsjedniku. Prevaranti koji koriste glasovne klonove već su se predstavljali kao, na primjer, američki državni tajnik Marco Rubio kako bi komunicirali s ministrima vanjskih poslova drugih država. Zaposlenik multinacionalne tvrtke sa sjedištem u Hong Kongu poslao je 25 milijuna dolara prevarantu koji je koristio deepfake kako bi se predstavio kao glavni financijski direktor tvrtke, izvijestio je CNN 2024. godine.

Bloomberg Businessweek

Bloomberg Businessweek

Sada, u nedostatku boljih rješenja, i pojedinci i institucije smišljaju vlastite neformalne Turingove testove u hodu. Podvrgavaju se novim provjerama koje često prkose postojećim društvenim normama kako bi potvrdili da nisu roboti te isto očekuju od drugih. Kako strojevi postaju sve bolji u oponašanju ljudi, ljudi mijenjaju način na koji se ponašaju. Mijenjaju način na koji pišu, način na koji zapošljavaju i način na koji komuniciraju s nepoznatima, sve kako bi izbjegli da ih se zamijeni za umjetnu inteligenciju – ili da ih umjetna inteligencija zamijeni.

Elizabeth Zaborowska nekoć je u svom uredu bila poznata kao "kraljica dugih crtica", toliko da su njezini kolege na njezinom prvom marketinškom poslu u New Yorku objesili znak na kojem je to pisalo kraj njene radne postaje. Zaborowska je taj interpunkcijski ukras vidjela kao elegantan način spajanja dviju ideja bez pretjeranog kompliciranja rečenice. Kada je pokrenula vlastitu tvrtku za odnose s javnošću, Bhava Communications, njezin je tim usvojio njen stil pisanja pa tako i duge crtice. No, ChatGPT također voli duge crtice te su one sada uvrštene na kratki popis retoričkih trikova koje ljudi smatraju pokazateljima teksta napisanog pomoću umjetne inteligencije. U trenutku kada tvrtke otpuštaju stručnjake za odnose s javnošću i okreću se besplatnim AI alatima, Zaborowska nije mogla riskirati da itko pomisli da rad chatbota predstavlja kao vlastiti. Prošlog proljeća okupila je svoj tim na tjednom virtualnom sastanku i naredila da se duga crtica zauvijek izbaci iz upotrebe (valja napomenuti da OpenAI radi na tome da se njegov chatbot odvikne od korištenja dugih crtica).

Od svih problema uzrokovanih umjetnom inteligencijom, to je bila najmanja žrtva. Međutim, za Zaborowsku je to odricanje imalo šire implikacije: kako bi zvučala ljudski, morala je potisnuti svoje instinkte. "To mijenja ritam jezika", tvrdi ona, "a ja sam opsjednuta jezikom."

Za Saru Suzuki Harvard, copywritericu u tvrtki storyarb, internetski napori da se razotkriju tekstovi napisani umjetnom inteligencijom pretvorili su se u "lov na vještice" koji ju je natjerao da cenzurira vlastiti rad. Nedavno je na LinkedInu govorila o svim uobičajenim stilskim konstrukcijama koje se sada smatraju znakovima umjetne inteligencije. Frustrirajuće je što su svi ti tobožnji pokazatelji zapravo ljudske osobitosti koje su računala naučila. "Mi smo ti koji su izgradili strojeve", kaže Suzuki Harvard. "Oni plagiraju od nas."

Kako god bilo, na ljude je pao teret da se dokazuju. Problem je možda najizraženiji na sveučilištima, gdje profesori koriste Reddit kako bi razmijenili strategije za razotkrivanje studenata koji varaju pomoću ChatGPT-ja, a studenti se na TikToku žale zbog nepravednog kažnjavanja jer se njihov trud zamjenjuje za djelo umjetne inteligencije. Urednici Wikipedije u međuvremenu su se udružili kako bi uklonili članke generirane umjetnom inteligencijom, što postižu pregledavanjem stranice za očite znakove poput lažnih citata i one manje očite poput prekomjerne upotrebe engleskog glagola delve.

Cilj nije eliminirati sav sadržaj stvoren umjetnom inteligencijom na Wikipediji, kaže Ilyas Lebleu, osnivač uredničke grupe WikiProject AI Cleanup, već riješiti se smeća. "Ako su informacije točne i postoje stvarni citati, to je dobro", kaže Lebleu. "Najveći problem je neprovjereni AI sadržaj."

U svijetu zapošljavanja, generativna umjetna inteligencija olakšala je svima da jednim klikom izrade detaljnu prijavu za posao, što je dovelo do poplave motivacijskih pisama i životopisa koje preopterećeni timovi za ljudske potencijale moraju pregledavati. Kyle Arteaga, izvršni direktor komunikacijske tvrtke Bulleit Group sa sjedištem u Seattleu, kaže da njegova tvrtka od nedavno prima po više tisuća prijava za jedno radno mjesto te da kandidati koriste umjetnu inteligenciju u tolikim razmjerima da se često uopće ni ne sjećaju da su se prijavili. Njegov tim je na to odgovorio postavljanjem zamki za umjetnu inteligenciju u oglase za posao: kandidati su morali u motivacijsko pismo uključiti jednu referencu na pop kulturu i navesti kojem domu u Hogwartsu pripadaju. Nedavno je na jednom natječaju, kaže Arteaga, manje od 3 posto od više od 900 osoba slijedilo upute, što je dramatično smanjilo broj kandidata (za informaciju, na kraju je zaposlen pripadnik Ravenclawa.)

Što su analogna rješenja?

Kako bi smanjili rizik od AI prevara, ljudi se također okreću nečemu što Farid naziva "analognim rješenjima". Altman iz OpenAI-a nedavno je predložio da bi jedna obrana od glasovnih klonova koji se predstavljaju kao bližnji mogla biti da obitelji smisle tajne šifre kojima se mogu poslužiti u kriznim vremenima. Krajem prošle godine, Starling Bank sa sjedištem u Velikoj Britaniji pokrenuo je marketinšku kampanju u kojoj je potaknuo svoje klijente da učine isto. Prema Starlingu, 82 posto ljudi koji su vidjeli poruku rekli su da će vjerojatno poslušati savjet.

Drugi se oslanjaju na provjerena trik-pitanja kako bi prepoznali ljudska bića na internetu. Tijekom nedavnog razgovora s agentom online korisničke službe, Pranava Adduri kaže da je zamolio agenta da definira Navier-Stokesovu jednadžbu, skup matematičkih jednadžbi koje opisuju gibanje viskoznih tekućina. Svaki vrijedan chatbot, obučen za sva svjetska znanja, rado bi dao odgovor, kaže Adduri, suosnivač i glavni tehnološki direktor sigurnosne tvrtke Bedrock Data Inc. sa sjedištem u Menlo Parku u Kaliforniji. No, ovaj je agent samo odgovorio: "Nemam pojma."

"Zaključio sam: 'U redu, ti si očito čovjek'", tumači Adduri.

Bloomberg Businessweek

Bloomberg Businessweek

Sve veći broj tvrtki, uključujući Google, vraća razgovore uživo, kojima chatbotovi u pravilu ne mogu prisustvovati. Glasnogovornik Googlea kaže da je tvrtka napravila tu promjenu kako bi nove zaposlenike upoznala sa svojom kulturom te "kako bi se osiguralo da kandidati imaju osnovne vještine programiranja potrebne za radna mjesta na koja se prijavljuju".

No, Google i druge velike korporacije imaju i druge dobre razloge zašto se žele osobno upoznati s novim zaposlenicima. Prema FBI-u, prikriveni sjevernokorejski radnici u IT sektoru uspješno su se zaposlili u više od 100 američkih tvrtki predstavljajući se kao zaposlenici na daljinu. Takve prevare, koje se često izvode pomoću alata umjetne inteligencije, godišnje su Sjevernoj Koreji donijele stotine milijuna dolara, a uplele su i američke pomagače.

"Nije tajna da postoje lažni kandidati", kaže Kelly Jones, glavna direktorica za ljudske potencijale tvrtke Cisco Systems Inc., te nadodaje da je tvrtka uvela biometrijsku provjeru u svoj proces prijave.

Rastuća potražnja za dokazima o ljudskosti očekivano je dovela do nastanka ekonomije tehnoloških rješenja. S jedne strane su alati za otkrivanje deepfakeova koji se priključuju na postojeće platforme, poput Zooma, i navodno otkrivaju sintetički audio i video u stvarnom vremenu. JPMorgan Chase & Co. koristi jedan takav alat pod nazivom Reality Defender na svojoj komunikacijskoj mreži. Farid je suosnivač vlastite tvrtke GetReal Security koja također nudi otkrivanje deepfakeova u stvarnom vremenu, kao i druge usluge digitalne forenzike.

S druge strane su alati koji provjeravaju jesu li ljudi zaista ljudi putem kriptografskih ili biometrijskih metoda. Najpoznatiji takav alat je Orb, uređaj za skeniranje očne jabučice koji je razvila tvrtka Tools for Humanity koju je suosnovao Altman. Orb skenira šarenice ljudi te proizvodi identifikacijski kod koji su njegovi tvorci usporedili s digitalnom putovnicom. Taj se kod, nazvan World ID, zatim može potvrditi pomoću aplikacije kad god korisnik treba potvrditi svoj identitet. Iako programeri tvrde da sustav ne pohranjuje nikakve osobne podatke o korisnicima, ideja je izazvala popriličan distopijski strah. Neke su ga zemlje, poput Brazila, čak i zabranile.

Orb i druge ideje za dokazivanje ljudskosti oslanjaju se na jedan entitet, bilo da se radi o privatnoj tvrtki, vladi ili nevladinoj organizaciji, za izdavanje potvrde, što stavlja ogromnu moć u ruke izdavatelja. To su ujedno i dugoročna rješenja koja zahtijevaju široko društveno i institucionalno prihvaćanje, a kada je riječ o krizi povjerenja na internetu, Farid tvrdi: "Trenutno smo u problemu."

Svako od ovih navodnih rješenja, od ukidanja dugih crtica do Orba, uključuje kompromise, bilo da se od ljudskih bića traži da se odreknu malih dijelova sebe ili da se sam čin ljudskosti pretvori u nekakvu vrstu performansa. Došli smo do točke u evoluciji umjetne inteligencije gdje smo istrenirali probabilističke strojeve da budu malo previše dobri u predviđanju toga što bi čovjek učinio u bilo kojoj situaciji. Sada, da bismo se razlikovali od njih, zapeli smo na upravo na tom zadatku.

.png)