Vodeći chatbotovi nisu namijenjeni psihoterapiji, no neki ih ljude rabe i za to.

Milo Van Slyck propustio je sastanak sa psihoterapeutkinjom početkom travnja, pa je odlučio isprobati nešto novo: svoje je probleme ispričao ChatGPT-u.

Tijekom tipkanja ovaj je pravnik iz Charlestona u Južnoj Karolini osjetio neugodu zbog iznošenja privatnih problema. Ispričao je chatbotu OpenAI svoje strahove i frustracije s obzirom na to da je transrodan muškarac u doba kada su diljem zemlje prava transrodnih osoba na meti napada. Spomenuo je sukob s roditeljima koji ne podupiru njegov rodni identitet, kao i pripreme za njihov nadolazeći posjet.

"Kad je riječ o ponovnom susretu s roditeljima, važno je dati prioritet svojim potrebama i dobrobiti", odgovorio je chatbot. "Razmislite o onome što vam je potrebno kako biste se osjećali ugodno i sigurno u njihovoj prisutnosti. U redu je postaviti granice u pogledu količine vremena koju ćete provesti s njima, temama o kojima ne želite razgovarati i načinu na koji se obraćaju vama i vašem identitetu."

U nadolazećim je danima Van Slyck stekao naviku slanja po nekoliko poruka kad si je želio dati oduška i osjetio da mu odgovori ChatGPT-a pružaju olakšanje. Kaže da se često osjeća kao teret drugima, čak i svojoj psihoterapeutkinji, no ne osjeća se kao da se nameće chatbotu. "Ponudit će vam ono što želite čuti od prijatelja ili osobe koja vam u životu pruža

podršku", rekao je Van Slyck. "Pružio mi je ohrabrenje koje ponekad jednostavno želite čuti od nekoga drugog (ili u ovom slučaju, nečeg drugog)."

Nova generacija chatbotova temeljenih na umjetnoj inteligenciji (eng. Artificial Intelligence – AI) još je u povojima, a dok se milijuni ljudi igraju s ChatGPT-om i drugim botovima, još se uvijek ne zna koje će primjene nakon te inicijalne faze opstati. Ljudi se koriste chatbotovima za pretraživanje interneta, varanje u zadaćama, pisanje softverskog koda i rezervaciju stola u restoranu. Bloomberg Businessweek nedavno je razgovarao sa šačicom ljudi koji su, baš poput Van Slycka, ChatGPT počeli upotrabljavati kao svojevrsnog roboterapeuta.

Zamisao o upotrebi chatbota u terapeutske ili trenerske svrhe nije bez presedana. Zapravo, profesor na Massachusetts

Institute of Technologyju (MIT) Joseph Weizenbaum je 1960-ih osmislio jedan od prvih chatbotova, Elizu, koja je imitirala psihoterapeuta. Nekoliko chatbotova poput Woebota i Wysa usmjereni su upravo na mentalno zdravlje. Za razliku od ljudskih terapeuta, chatbotovi se nikada ne umaraju i daleko su jeftin.

Međutim, postoje i potencijalni nedostaci. Snažni chatbotovi za široku upotrebu poput ChatGPT-a, Barda kompanije Google i Bing Chata koji pokreće OpenAI korporacije Microsoft temelje se na velikim jezičnim modelima, tj. tehnologiji s dokazanom tendencijom izmišljanja informacija koje zvuče uvjerljivo. Chatbotovi za široku upotrebu nisu namijenjeni

terapiji niti su programirani u skladu s etičkim i pravnim smjernicama kojih se pridržavaju ljudski terapeuti. U svojem sadašnjem obliku, također nemaju kako pratiti što im korisnici govore iz sastanka u sastanak. To je nedostatak koji većina pacijenata vjerojatno ne bi tolerirala kod svojih ljudskih terapeuta.

"Ako netko boluje od ozbiljne psihičke bolesti, ovaj program nije spreman preuzeti mjesto stručnjaka", rekao je Stephen Ilardi, klinički psiholog i profesor na Sveučilištu u Kansasu koji proučava poremećaje raspoloženja. "Rizik je prevelik." Ilardi kaže da je ChatGPT poput "salonskog trika". Ipak, smatra da je dovoljno dobar sugovornik koji bi mnogim ljudima mogao biti od pomoći.

Glasnogovornik društva OpenAI sa sjedištem u San Franciscu odbio je komentirati činjenicu da ljudi chatbot upotrebljavaju u terapeutske svrhe, no ukazao je na uvjete upotrebe u kojima stoji da ljudi "ne smiju upotrebljavati OpenAI modele kako bi postavljali dijagnoze ili liječili ozbiljna zdravstvena stanja". Kad je Van Slyck komunicirao s ChatGPT-om, chatbot ga je upozorio da nije psihoterapeut, istovremeno ga pozivajući da ga nastavi upotrebljavati u tu svrhu. Prisjeća se kako je chatbotu rekao o objavi na Twitteru koja navodi da je chatbot učinkovitiji od terapije uživo. "Važno je napomenuti da mrežni resursi mogu pomoći, no nisu zamjena za stručnu pomoć ako se borite s traumama ili problemima s psihičkim zdravljem", odgovorio je ChatGPT. "S tim na umu, ako imate konkretnih pitanja ili nedoumica, dat ću sve od sebe da vam pomognem s informacijama."

Van Slyck, koji godinama ide na terapiju uživo, kaže da ne planira prestati odlaziti na terapiju te da bi se posavjetovao sa psihoterapeutkinjom o svim odlukama prema kojima ga ChatGPT usmjeri. "Dosad mi se ono što mi je predlagao činilo kao vrlo razumna i pronicljiva povratna informacija", rekao je.

Bloomberg Businessweek

Bloomberg Businessweek

Ilardi kaže da može zamisliti da ChatGPT, uz prave smjernice, bude prilagođen za upotrebu kao dopuna stručnoj skrbi u slučajevima kad potražnja za psihoterapijom premašuje ponudu. Margaret Mitchell, glavna znanstvenica na području etike u društvu Hugging Face koje se bavi proizvodnjom i podrškom AI modela, smatra da bi se takvi chatbotovi

mogli upotrebljavati za pomoć ljudima koji rade na telefonskim linijama za pomoć u kriznim situacijama kako bi povećali broj poziva na koje mogu odgovoriti.

Međutim, Mitchell brine da bi ljudi koji se obraćaju chatbotovima za terapiju mogli pogoršati svoje probleme, a da u tom trenutku nisu svjesni da to čine. "Čak i ako netko tehnologiju smatra korisnom, to ne znači da ih ona vodi u dobrom smjeru", rekla je.

Mitchell ukazuje i na zabrinjavajuće mogućnosti narušavanja privatnosti. OpenAI pregledava razgovore korisnika i upotrebljava ih za obuku, što se možda neće svidjeti korisnicima koji žele razgovarati o iznimno osobnim problemima. (Korisnici mogu izbrisati račun, no taj postupak može potrajati i do četiri tjedna.) U ožujku je pogreška u sustavu navela OpenAI da nakratko isključi ChatGPT nakon što je primio izvješće u kojemu se navodi da neki korisnici mogu vidjeti naslove povijesti razgovora drugih korisnika.

Čak i ako privatnost ostavimo postrance, neki ljudi roboterapiju jednostavno smatraju suviše čudnom. Aaron Lawson, voditelj projekata u elektrotehničkom društvu u San Diegu, uživao je eksperimentirajući s ChatGPT-om i pokušao ga navesti da preuzme ulogu pristupačnog psihoterapeuta. Njegovi su odgovori zvučali dovoljno ljudski, ali Lawson nije mogao prijeći preko činjenice da ne razgovara sa stvarnom osobom. "Naredio sam mu da glumi", rekao je. "Teško mi je sudjelovati u tome."

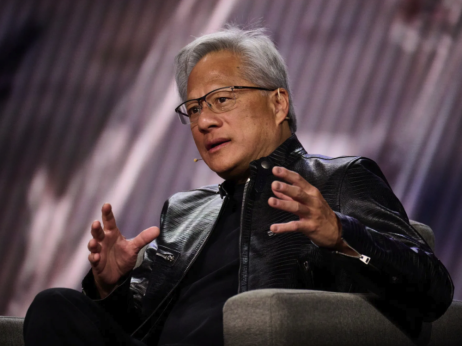

S druge strane, Emad Mostaque je na konferenciji u ožujku rekao da svakodnevno upotrebljava ChatGPT 4, najmoćniji model koji OpenAI nudi javnosti. Mostaque, osnivač i glavni izvršni direktor društva Stability AI koje je populariziralo generator slika Stable Diffusion, opisao je chatbota kao "najboljeg terapeuta".

U naknadnom je intervjuu Mostaque rekao da je konstruirao upute koje ubacuje u chatbot kako bi ga natjerao da se ponaša više poput ljudskog terapeuta. Kaže da s njim razgovara o nizu tema: kako se nositi sa stresom vođenja novog društva za umjetnu inteligenciju (posebice kao netko tko javno govori o svojoj neuroraznolikosti i poremećajima pažnje te hiperaktivnosti), kako dati prednost određenim dijelovima svojega života i kako se nositi s osjećajem preopterećenosti. Zauzvrat mu chatbot daje „dobre i vrlo razumne savjete“, poput mehanizama za suočavanje za učinkovitije balansiranje života.

Mostaque kaže da chatbotove ne smatra zamjenom za ljudske psihoterapeute, no smatra da mogu biti od pomoći kada želite razgovarati s nekime, a nemate s kime. "Nažalost, ljudi se teško prilagođavaju", rekao je.

Upotreba chatbota kao psihoterapeuta u nuždi već se svidjela nekim ljudima, no oslanjanje na softver koji oponaša stručnjaka može imati nedostatke

.png)